[Week 4- Day 2] 회고

# Convolution

signal processing 에서 2개의 함수를 잘 섞어주는 연산자

# CNN

Convolution 층 + Dense 층 으로 구성

- Stride = patch size/ stride

- Channel = Output size

- Params size는 대강 파악하는 게 중요! (img-filter+1)

- Padding (입출력 size간의 크기에 따라 diff)

Q. Why 1*1 Convolution?

-> 차원/ 파라미터 수 줄이기 위해

## CNN 응용 모델

## CV Task

- Semantic Segmentation (이미지의 모든 pixel마다 예측 및 분류)(dense 분류)(per pixel)(ex. 자율주행)

- Detection (바운딩 박스로 바꿔서 예측 및 분류)

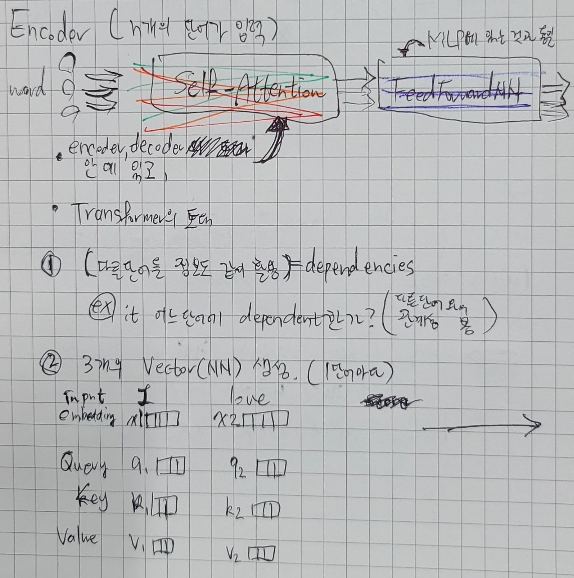

# Transformer

(Encoder-Decoder 구조)(동일한 구조를 갖지만, NW가 다르게 stack됨)

중요하게 봐야 할 포인트

- n개의 단어가 how to NW에서 한 번에 처리?

- Encoder-Decoder 사이에 어떤 정보를 주고 받는지?

- Decoder가 how to generate?

## 피어 세션

미션 : 자체 팀 구성 진행, 이번 주 멘토링 수 1시

다들 엄청 잘해서 약간 내가 프로젝트에 기여할 수나 있을까 하는 생각이 잠시 들었다.

정말 사람의 기억력의 3일 가는 것 같다.

CNN 수업을 대학에서 듣고, 프리코스에서도 듣고, 여기서 또 듣는데 기억이 안난다. 우와 신기.

그나마 다행인 거는 LSTM은 이해도 못했다는 것이다 ㅋㅋ..

생성 모델도 가르쳐줘서 감사했다. 배워보고 싶었는데!

다른 팀원이 RNN 퀴즈 2번 문제를 질문했었는데, 아까 나도 풀어보았다.

1이 나왔는데, 알고보니 Attention(저 Softmax()에서 나온 Scaler값 하나) 각각에 대해 Value Vector를 곱하는 것이었다.

DL은 진짜 어떤 차원dim인지 너무너무너무너무 헷갈린다.

어느 축이 어디고, 이 인덱스가 내가 바라는 차원인지, 일부러 안알려주려고 그러나하는 생각까지 든다.

행렬을 안배워서 그런 것 같기도? 도대체 얼마나 엄청난 과목인걸까.. 과거시험을 보고 싶군(?)